Attention aux images sensationnelles… et racistes générées par IA

Dernière modification : 12 août 2024

Autrice : Lili Pillot, journaliste

Relecteur : Etienne Merle, journaliste

Liens d’intérêts ou fonctions politiques déclarés des intervenants à l’article : aucun

Secrétaire de rédaction : Lili Pillot, journaliste

Source : Post Facebook, 30 juillet

Sur Facebook, Instagram ou encore Pinterest, des images montrant des enfants noirs réalisant de somptueuses sculptures avec des déchets, se multiplient. Générées par l’intelligence artificielle, elles ne font que renforcer des stéréotypes racistes véhiculés par l’IA.

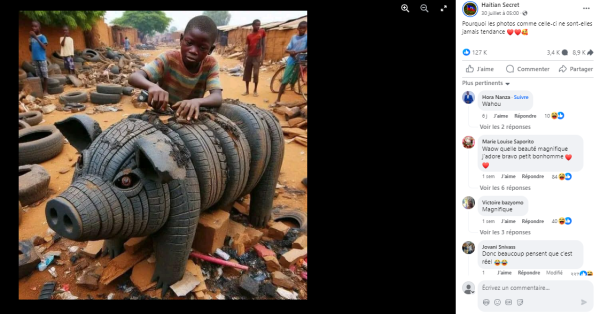

“Pourquoi les photos comme celle-ci ne sont-elles jamais tendances ?”, se désole un internaute sur Facebook qui publie une image quelque peu sensationnelle. On y voit un petit garçon noir sculpter des pneus pour en représenter un superbe cochon. Il se trouve au milieu d’une rue jonchée de déchets, où d’autres enfants se tiennent debout, derrière lui.

En réalité, le cliché n’est pas une photo à proprement parler, mais une image générée par l’intelligence artificielle qui présente une vision stéréotypée de l’Afrique. Et ce n’est pas un cas isolé.

On en trouve de nombreuses similaires qui circulent sur Internet. Souvent, les internautes ne remettent pas en cause la véracité de l’image et s’extasient de l’ingéniosité de ces enfants, malgré leurs présumées conditions de vie difficiles. “La pauvreté ne tue pas la créativité”, affirme un autre internaute.

Si détecter l’utilisation d’image artificielle (IA) n’est pas toujours compliqué, il est important de rappeler que de nombreuses études scientifiques prouvent que les algorithmes des IA reproduisent les stéréotypes humains, y compris racistes. Il faut donc redoubler de prudence quand nous sommes confrontés à de telles images.

Des photos aux couleurs saturées et trop parfaites

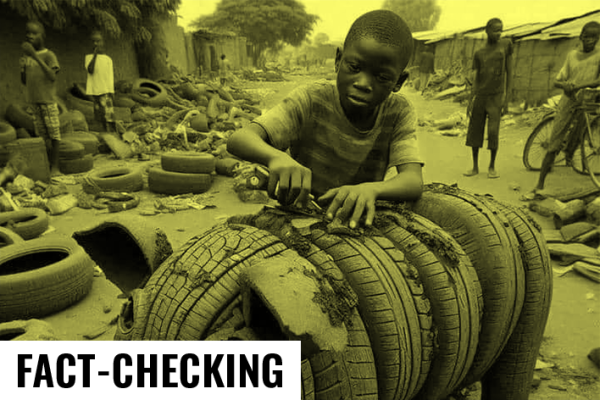

La première fois que Les Surligneurs ont vu cette photo, nous avons eu de gros doutes sur la réalité de cette photographie. Quasiment toutes les caractéristiques de l’image créée par IA sont réunies : une régularité des couleurs, une allure de perfection par endroits et des flous mal maîtrisés. Mais nous pouvons nous tromper.

Pour en avoir le cœur net, nous avons choisi de passer l’image dans un outil de détection d’image générée par IA. Résultat : le logiciel indique qu’il y a 100 % de chances que l’image en question ait été générée par IA. Nous avons fait un comparatif avec une vraie photo pour vérifier que le logiciel est fiable. Ce qui a fonctionné.

En effectuant une recherche Google image inversée, on se rend compte que cette image fait partie d’une sorte de série de photos du même style. À chaque fois quasiment, des enfants noirs sont mis en scène dans des rues sales, remplies de déchets. Ils sont en train de jouer ou de créer des objets d’art particulièrement sophistiqués. En commentaires, nombreux sont ceux qui croient à la véracité de ces photographies et complimentent les enfants qu’ils représentent. “Waow quelle beauté magnifique j’adore bravo petit bonhomme”, encourage une internaute.

Capture d’écran d’une publication Facebook

Apprendre à savoir repérer une image IA

Mais tous ne tombent pas dans le panneau. Dans un post Facebook, une artiste avertie que cette série d’images est générée par IA. Elle soulève les mêmes points que nous avions notés : les images semblent “parfaites”, avec un genre de filtre lisse. Elle note aussi que parfois les yeux sont un peu trop grands.

Mais surtout, l’artiste fait remarquer une caractéristique commune à toutes ces images : elles font appel à la sentimentalité, c’est-à-dire qu’elles sont générées pour provoquer une réaction, bonne ou mauvaise, chez le spectateur. Pour cette série d’images, l’internaute questionne : “Qu’est-ce que communiquent comme message ces images ? Quel est le thème de cette série ?”.

Si nous ne sommes pas parvenus à remonter à la source originale de la génération de ces images, il n’y a que peu de doute sur l’intention de leur diffusion. On l’observe notamment dans les légendes des republications. Le texte tente de provoquer un sentiment de pitié ou de compassion. “Oui, la pauvreté est laide, mais les pauvres sont très beaux. […] Le garçon a fait ça avec des choses très simples, mais personne ne l’a aimé”, écrit en arabe un internaute. “Encouragez ce garçon et évaluez son travail”, poste un autre, en portugais.

Biais et stéréotypes racistes

Force est de constater que dans cette série d’images, la mise en scène est toujours celle d’un enfant noir, dans un paysage pauvre et sale ou rural, mais qui parait toujours heureux. Souvent, le texte qui accompagne la photo diffuse un discours d’optimisme quelque peu forcé, comme on peut le voir dans cette publication LinkedIn.

Une étude publiée dans le magazine scientifique The Lancet Global Health a prouvé, fin 2023, que l’IA Midjourney renforçait les perceptions racistes que peut avoir un humain.

Alors que les experts ont demandé à l’IA de produire des images de médecins noirs soignants des enfants blancs, pour essayer de démontrer justement que les stéréotypes intégrés étaient un mythe, Midjourney a échoué. “Les patients avaient parfois la peau de couleur noire et l’outil ajoutait des éléments africains exagérés et culturellement offensants”, écrivent les chercheurs dans leur rapport.

Une représentation tronquée par rapport à la réalité, sur laquelle l’UNESCO a déjà alerté. Pour contrer ce phénomène, l’instance onusienne fait une recommandation : “avoir des équipes d’ingénieurs plus diverses”. “Nous appelons les gouvernements à élaborer et à faire appliquer des cadres réglementaires clairs, et les entreprises privées à effectuer un suivi et une évaluation continus des préjugés structurels”, a précisé la directrice générale de l’UNESCO, Audrey Azoulay.

En attendant qu’une meilleure réglementation de ces productions soit établie, Les Surligneurs vous invitent à redoubler de prudence face à une image qui provoque chez vous une vive émotion. Et à vous demander quel message pourrait se cacher derrière ces images.